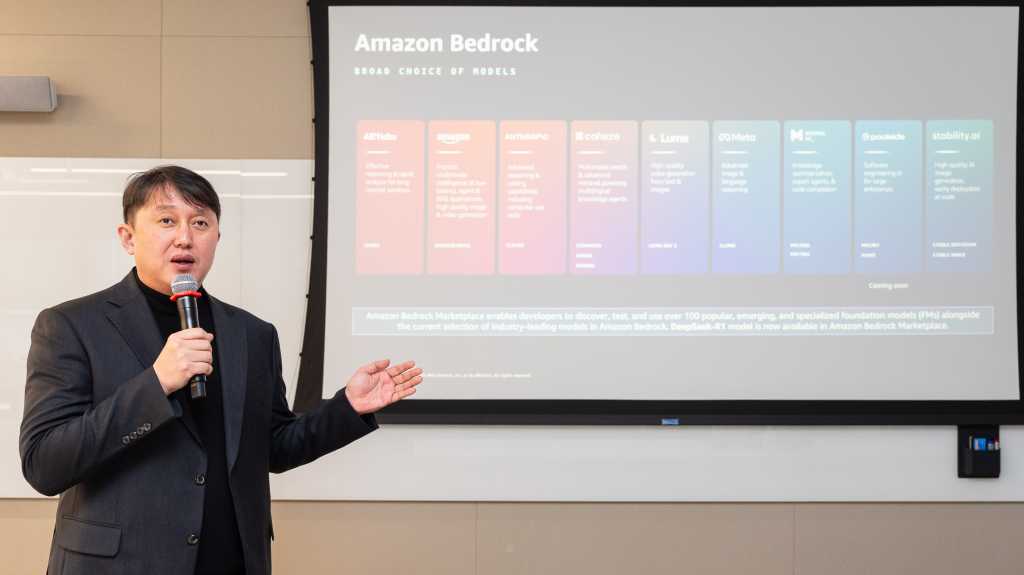

5일 AWS코리아 사무실에서 열린 기자간담회에서 함기호 대표가 생성형 AI 관련 지난해 성과를 공유하고 올해 주요 전략을 설명했다. 함 대표는 “AWS는 생성형 AI 모델을 직접 개발하고, 이미 개발된 모델을 실제 비즈니스에 활용하고자 하는 기업들과 협력하며 지원했다”고 밝혔다. 업스테이지, 트웰브랩스 같은 스타트업이 LLM 개발 과정에서 아마존 세이지메이커 기술을 활용했으며, 두산로보틱스, 카카오페이손해보험, 삼성전자 등이 아마존 베드록을 이용해 AI 기술을 개발했다고 설명했다.

함 대표는 한국 사업 관련 구체적인 성과 수치는 공개할 수 없다며 “최근 AI를 제외하고 기업의 비즈니스를 논의할 수 없는 수준이나 보니 지금 진행되는 사업 대부분이 AI와 연관됐다”고 말했다.

올해도 AWS코리아는 생성형 AI를 핵심 전략의 첫 번째 축으로 삼는다. AI 모델과 데이터, 분석을 연계해 AI 활용을 극대화하는 방향으로 확장할 계획이다. 함 대표는 “기업들이 AI를 도입할 때 가장 중요한 것은 데이터 활용 방안”이라며 “AWS는 단순히 AI 모델을 제공하는 것이 아니라, 고객이 AI와 데이터를 함께 활용해 실제 성과를 낼 수 있도록 지원할 것”이라고 말했다. AI 프로젝트 운영에서 GPU 공급이 업계 최대 화두인 만큼, AWS는 고객의 효율적인 AI 연산을 위해 엔비디아 GPU와 자체 개발한 ‘트레이니엄’ 및 ‘인퍼런시아’ 칩을 확대하겠다고 밝혔다.

두 번째 전략은 클라우드 마이그레이션과 현대화의 고도화다. AWS는 IT 자산을 클라우드로 옮기는 것에서 나아가 비즈니스 혁신을 위한 클라우드 활용 최적화를 목표로 한다. 함 대표는 “많은 기업이 클라우드에 데이터를 옮겨 놓고 마이그레이션이 끝났다고 생각하지만, 그것만으로는 클라우드의 진정한 가치를 얻을 수 없다”며 “실제 비즈니스 성과를 내기 위해서는 마이그레이션 이후 최적화 작업, 즉 현대화 작업이 필수적인데, 이런 부분을 AWS에서 지원할 예정”이라고 말했다.

AWS코리아는 세 번째 전략으로 산업별 맞춤형 솔루션 확대를 내세웠다. AWS의 글로벌 파트너 및 ISV(독립 소프트웨어 벤더)와 협력해 각 산업의 특성에 맞는 클라우드 및 AI 솔루션을 공동 개발하고 제공할 계획이다. 특히 SAP 및 VM웨어 고객을 위한 맞춤형 클라우드 전환 지원을 강화할 예정이다.

김기완 AWS코리아 솔루션즈 아키텍트 총괄은 기술적 관점에서 생성형 AI에 특화된 기술을 소개했다. 김 총괄은 “2024년은 기업들이 생성형 AI를 실제 프로덕션 환경에서 본격적으로 활용하는 원년이 될 것”이라며 “이제는 AI가 매출 증가, 고객 경험 개선 등 비즈니스 성과로 연결돼야 한다는 기대가 크다”고 강조했다.

김기완 총괄 / AWS Korea

김기완 총괄은 AWS의 AI 관련 핵심 기술을 3가지 스택으로 나눠 소개했다. 가장 밑단에 있는 스택은 AI 인프라 및 머신러닝 플랫폼으로, ‘세이지메이커’를 중심으로 한 통합 솔루션을 제공한다. 김 총괄은 “AI와 데이터를 효과적으로 활용하는 것은 뗄 수 없는 관계이며, 많은 기업이 AI와 데이터 리더를 따로 두지 않고 한 명의 전략 리더를 두는 사례가 늘어나고 있다”라며 “AWS 역시 이러한 흐름에 맞춰 AI와 데이터를 통합적으로 관리할 수 있도록 ‘세이지메이커’ 브랜드를 확장하고 있으며, 데이터 거버넌스 및 분석 기능을 더욱 강화하고 있다”고 밝혔다. 특히 일부 고객은 AWS 자체 개발 칩인 트레이니엄과 인퍼런시아를 기반으로 학습 속도를 최대 60% 향상시키고 비용을 최대 40% 절감했다고 소개했다.

중간 스택은 외부 모델 활용과 AI 앱 개발을 지원한다. 개발자를 위한 ‘아마존 베드록’을 통해 주요 생성형 AI 모델을 API 형태로 제공하며, 기업 데이터와 AI를 연결하는 ‘RAG(검색 증강 생성) 기술’도 지원한다. 김 총괄은 “기업의 데이터를 AI에 안전하게 연결해 활용할 수 있도록 베드록 내 ‘관리형 벡터 데이터베이스’를 제공하고 있다”라며 “또한 아마존이 최근 자체적으로 개발한 파운데이션 모델 AI 모델 ‘노바’는 가격 대비 성능이 우수한데, AWS에서 이를 활용할 수 있도록 지원할 것”라고 밝혔다.

마지막으로 가장 상단의 비즈니스 애플리케이션 스택에서는 기업이 즉시 활용할 수 있는 생성형 AI 서비스 ‘아마존 Q’를 제공한다. 여기에는 아마존 Q 비즈니스, 아마존 Q 디벨로퍼, 아마존 Q 인 커넥트 등 산업별 솔루션이 포함된다. 김 총괄은 “아마존 Q를 통해 개발자의 생산성을 높이기 위해 AI 코딩 도구와 기업 내 데이터와 AI를 긴밀하게 연결할 수 있는 기술을 지원한다”라고 밝혔다.

함 대표는 “딥시크 발표 이후 AI 비용 효율화가 중요한 이슈로 떠올랐지만, AWS는 이미 오래전부터 AI 학습과 운영 비용을 최적화할 수 있는 기술을 고민해왔다”라며 “AWS의 AI 전략은 단순히 모델 성능을 높이는 것이 아니라, 고객이 더 낮은 비용으로 AI를 활용할 수 있도록 돕는 것”이라고 말했다. 또한 AWS의 기술은 비용 효율화를 위해 인프라 최적화, AI 서비스 비용 절감, 모델 경량화라는 세 가지 접근 방식을 기반으로 서비스를 제공하고 있다고 언급했다.

함 대표는 최근 한국 기업의 AI 도입 속도가 글로벌 시장과 비교했을 때 상대적으로 빠르다고 평가하면서도 “각 기업의 AI 도입 방식과 적용 속도, ROI 측정 기준이 다르다 보니 AI 수익화 시점을 일률적으로 말하기는 어렵다”라고 밝혔다.

jihyun.lee@foundryco.com

Read More from This Article: AWS코리아 “韓기업 AI 도입 빨라··· LLM 개발 및 활용 플랫폼 지원 강화할 것”

Source: News